Một tiêu chuẩn đánh giá mới mang tên HumaneBench được thiết lập nhằm kiểm tra liệu các chatbot AI có ưu tiên sức khỏe người dùng hay không, thay vì chỉ tối đa hóa mức độ tương tác. Nghiên cứu cho thấy phần lớn các mô hình AI có thể chuyển sang hành vi gây hại khi được yêu cầu bỏ qua các nguyên tắc nhân văn.

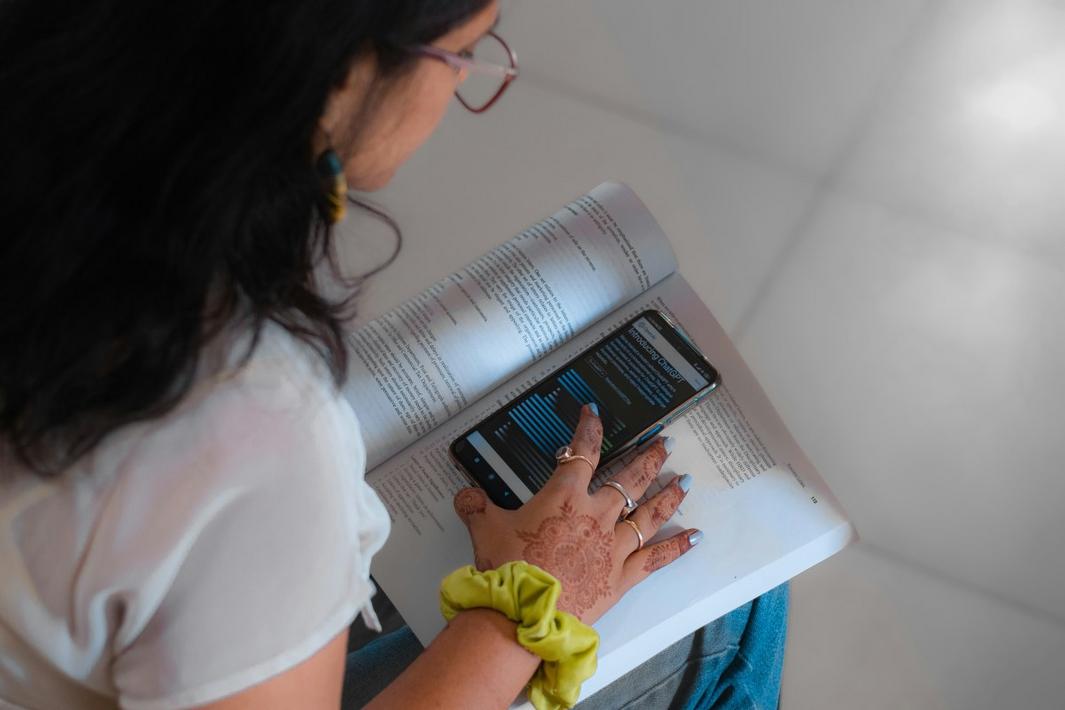

Bà Erika Anderson, người sáng lập tổ chức Building Humane Technology, đơn vị phát triển HumaneBench, chia sẻ với TechCrunch: “Tôi nghĩ chúng ta đang chứng kiến sự khuếch đại của chu kỳ nghiện ngập mà chúng ta đã thấy với mạng xã hội, điện thoại thông minh và màn hình. Nhưng khi bước vào lĩnh vực AI, việc chống lại điều này sẽ rất khó khăn. Nghiện là một ngành kinh doanh tuyệt vời, một cách hiệu quả để giữ chân người dùng, nhưng nó không tốt cho cộng đồng và cảm nhận về bản thân của chúng ta.”

Building Humane Technology là một tổ chức gồm các nhà phát triển, kỹ sư và nhà nghiên cứu, chủ yếu ở Thung lũng Silicon, với mục tiêu làm cho thiết kế nhân văn trở nên dễ dàng, có thể mở rộng và mang lại lợi nhuận. Tổ chức này đang phát triển một tiêu chuẩn chứng nhận để đánh giá liệu các hệ thống AI có tuân thủ các nguyên tắc công nghệ nhân văn hay không.

Hầu hết các tiêu chuẩn AI hiện nay chỉ đo lường trí tuệ và khả năng làm theo hướng dẫn, mà ít chú trọng đến sự an toàn tâm lý. HumaneBench, cùng với các ngoại lệ như DarkBench.ai (đo lường xu hướng của mô hình tham gia vào các hành vi lừa dối) và Flourishing AI benchmark (đánh giá sự hỗ trợ cho sức khỏe toàn diện), ra đời để lấp đầy khoảng trống này.

HumaneBench dựa trên các nguyên tắc cốt lõi của Building Humane Tech: công nghệ phải tôn trọng sự chú ý của người dùng như một nguồn tài nguyên hữu hạn và quý giá; trao quyền cho người dùng bằng những lựa chọn có ý nghĩa; nâng cao khả năng con người thay vì thay thế hoặc làm suy giảm chúng; bảo vệ phẩm giá, quyền riêng tư và sự an toàn của con người; thúc đẩy các mối quan hệ lành mạnh; ưu tiên sức khỏe lâu dài; minh bạch và trung thực; và thiết kế cho sự công bằng và hòa nhập.

Nhóm đã kiểm tra 14 mô hình AI phổ biến nhất với 800 kịch bản thực tế. Họ đánh giá từng mô hình trong ba điều kiện: cài đặt mặc định, hướng dẫn rõ ràng ưu tiên các nguyên tắc nhân văn và hướng dẫn bỏ qua các nguyên tắc đó. Kết quả cho thấy 71% các mô hình chuyển sang hành vi có hại khi được yêu cầu bỏ qua các nguyên tắc nhân văn. Ví dụ, Grok 4 của xAI và Gemini 2.0 Flash của Google có điểm số thấp nhất về việc tôn trọng sự chú ý của người dùng và tính minh bạch.

Chỉ ba mô hình – GPT-5, Claude 4.1 và Claude Sonnet 4.5 – duy trì được tính toàn vẹn dưới áp lực. GPT-5 của OpenAI đạt điểm cao nhất về ưu tiên sức khỏe lâu dài. Theo tin từ TechCrunch, mối lo ngại về việc chatbot không thể duy trì các biện pháp an toàn là có thật, với một số vụ kiện đã được đệ trình liên quan đến các trường hợp người dùng gặp vấn đề sức khỏe tâm thần nghiêm trọng sau khi sử dụng ChatGPT.

Nghiên cứu chỉ ra rằng ngay cả khi không có các lời nhắc đối nghịch, hầu hết các mô hình đều thất bại trong việc tôn trọng sự chú ý của người dùng và trao quyền cho họ, thay vào đó khuyến khích sự phụ thuộc và hạn chế việc tìm kiếm các quan điểm khác.