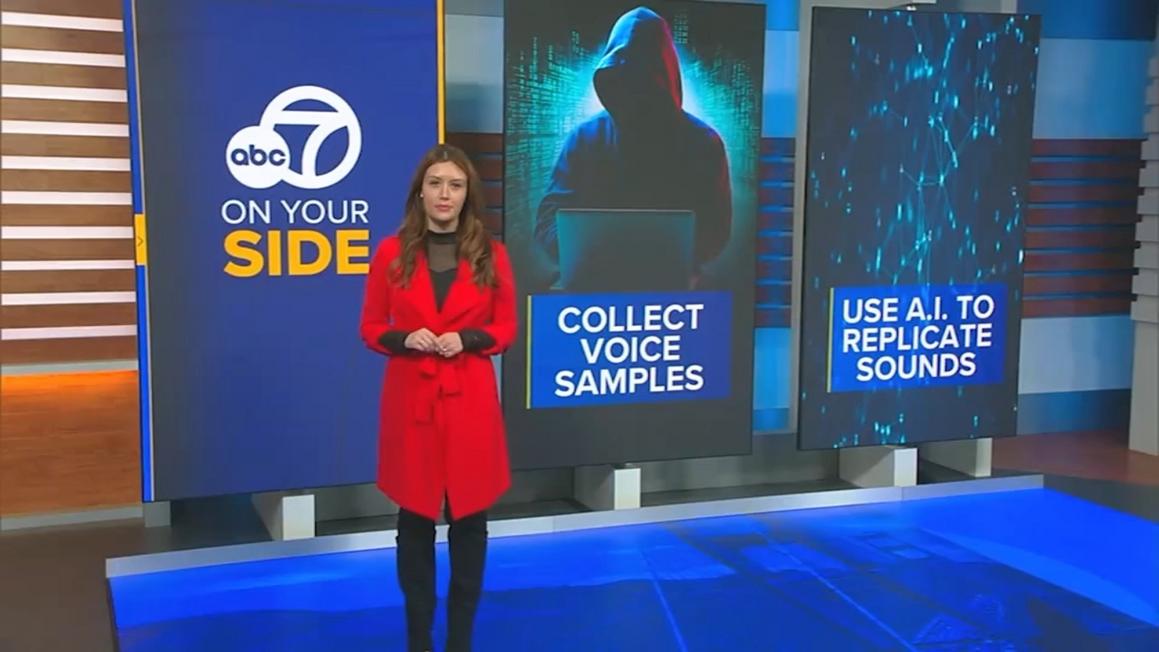

Trong thời gian gần đây, các chuyên gia an ninh mạng đang cảnh báo về sự gia tăng của các vụ lừa đảo sử dụng trí tuệ nhân tạo (AI), đặc biệt là hình thức giả giọng nói. Kẻ lừa đảo sử dụng công nghệ AI để tạo ra các bản sao giọng nói của người thân, bạn bè, nhằm mục đích tống tiền.

Kỹ thuật này hoạt động như sau: Kẻ xấu thu thập các đoạn ghi âm từ video trên mạng xã hội, hoặc thậm chí từ hộp thư thoại cá nhân của nạn nhân. Chỉ cần ba giây âm thanh là đủ để AI tái tạo giọng nói gần như hoàn hảo. Nhiều nạn nhân cho biết họ không thể phân biệt được đâu là giọng thật, đâu là giọng giả.

Sau khi có được bản sao giọng nói, kẻ lừa đảo sẽ gọi cho gia đình nạn nhân, giả vờ gặp phải tình huống khẩn cấp như tai nạn xe cộ hoặc các khoản chi tiêu bất ngờ, và yêu cầu chuyển tiền. Do tâm lý lo lắng và mất cảnh giác, nhiều người đã sập bẫy.

Theo một nghiên cứu của McAfee, 70% số người được hỏi không thể nhận ra sự khác biệt giữa giọng nói thật và giọng nói do AI tạo ra. Đáng lo ngại hơn, cứ 10 người được khảo sát thì có một người cho biết họ đã nhận được tin nhắn từ giọng nói AI giả mạo.

Hậu quả là nhiều người đã mất tiền. Hơn một phần ba số người bị lừa đã mất từ 500 đến 3.000 đô la Mỹ. Thậm chí, 7% trong số đó đã mất từ 5.000 đến 15.000 đô la Mỹ.

Các chuyên gia khuyến cáo mọi người nên thiết lập một “cụm từ bí mật” với người thân để xác minh danh tính khi nhận được các cuộc gọi đáng ngờ. Việc này giúp giảm thiểu rủi ro bị lừa đảo.

Theo ABC News, tình trạng lừa đảo bằng giọng nói AI đang ngày càng trở nên tinh vi và phổ biến, đòi hỏi mọi người phải nâng cao cảnh giác để bảo vệ bản thân và gia đình.